Recent searches

Search options

Der Kluger-Hans-Effekt: Wenn KI aus den falschen Gründen richtig liegt

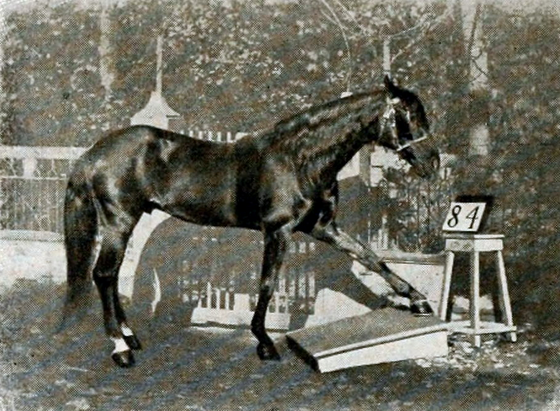

Eine #KI kann manchmal richtige Ergebnisse liefern – aber aus völlig falschen Gründen. Das nennt man den „Kluger-Hans-Effekt“. Der Name geht auf ein Pferd zurück, das Anfang des 20. Jahrhunderts scheinbar rechnen konnte. Tatsächlich las Hans aber nur die Körpersprache seines Besitzers und reagierte auf unbewusste Signale – nicht auf die Mathematik selbst.

https://de.wikipedia.org/wiki/Kluger_Hans

Eine aktuelle Studie in „Nature Machine Intelligence“ zeigt, dass dieser Effekt auch in der Künstlichen Intelligenz ein ernsthaftes Problem darstellt: KI-Modelle liefern manchmal korrekte Ergebnisse, weil sie Muster erkennen, die gar nichts mit der eigentlichen Aufgabe zu tun haben. Zum Beispiel klassifizierte ein medizinisches Modell Lungenbilder als COVID-positiv – nicht wegen der Krankheitssymptome, sondern wegen eines Wasserzeichens auf den Bildern.

https://www.nature.com/articles/s42256-025-01000-2

1/2

@gisiger@nerdculture.de

@gisiger@nerdculture.deWarum ist das problematisch?

Wenn #KI aufgrund solcher versteckten Muster entscheidet, kann das in kritischen Bereichen – etwa Medizin oder Qualitätskontrolle – zu fatalen Fehlern führen. Und das Fatale: Der Fehler bleibt oft lange unentdeckt, weil die Ergebnisse ja „korrekt“ scheinen.

Was kann man dagegen tun?

Hinterfrage die Ergebnisse einer KI kritisch – auch wenn sie auf den ersten Blick korrekt erscheinen.

Nutze erklärbare KI-Modelle (Explainable AI), um besser zu verstehen, warum die KI zu einer bestimmten Entscheidung gekommen ist.

Kombiniere maschinelle und menschliche Intelligenz – der Mensch bleibt ein wichtiger Kontrollfaktor.

2/2